在ubuntu 下面安装了opera后,然后安装了ibus,但却发现不能输入中文,然而ibus却可以在其它程序中输入中文的。经过调查发现,原因有二:

- 1. opera的快捷键与ibus快捷键冲突。 我的ibus启用快捷键是ctrl + space, 而opera的这个快捷键默认会打开home page。

- 2. ibus 输入法变量没有导出,opera得不到输入法参数。

网上很多人都找到了原因出在这里,但却有很多方案无法解决问题。经过很多试验,下面方案可以解决输入问题:

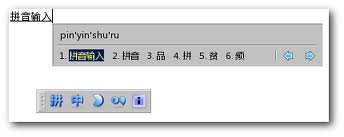

- 1.打开Opera–>Tools –> Preferences, 打开Andvanced 选项卡,在右侧点击 Shortcut, 点击右侧Keybord-Setup旁边的Edit按钮,在弹出的对话框最上面搜索栏输入

Space, 在下面的结果栏找到 Space ctrl, 然后删除它。如果您的ibus启用快捷键是别的,对应删除冲突即可。 - 2.创建sh文件 ibus.sh, 输入下面内容,

export QT_IM_MODULE=xim

export XMODIFIERS="@im=ibus"保存,然后 执行 sudo cp ibus.sh /etc/profile.d/

再次执行 sudo chmod +x /etc/profile.d/ibus.sh

注销登录,重新登录后 可以试试是否好用。对于其它版本linux也可相应解决。

我的相关软件版本信息:

ubuntu 10.04 64位,英文语言环境ibus 1.3.9

opera 11.51 64位